Con la crescente accelerazione dell’intelligenza artificiale e dell’automazione nel 2026, la sfida centrale per le organizzazioni non è più la capacità tecnica, ma la preservazione della responsabilità umana. Questo articolo sostiene che il rischio più significativo dell’IA non risiede né nella perdita di posti di lavoro né negli errori delle macchine, bensì nella sottile trasformazione della responsabilità in una caratteristica opzionale dei sistemi moderni. Attraverso impostazioni predefinite, raccomandazioni e flussi di lavoro automatizzati, la responsabilità non viene eliminata, ma progressivamente dispersa — fino a quando le decisioni vengono prese senza una chiara attribuzione.

L’articolo mostra come valori quali il giudizio, il pensiero critico e la responsabilità non scompaiano perché l’IA li sostituisce, ma perché i sistemi vengono progettati in modo tale da non richiederli più. Il controllo umano opzionale, il bias dell’automazione e i sistemi di performance ottimizzati per velocità e misurabilità erodono gradualmente la titolarità delle decisioni. Ciò che non può essere quantificato — contesto, interpretazione, giudizio di lungo periodo — perde visibilità, riconoscimento e valore economico.

Anziché opporsi all’IA, l’articolo invita a un design intenzionale dei sistemi che renda l’agenzia umana esplicita e non negoziabile nei punti critici. Preservare la responsabilità richiede ruoli decisionali chiari, revisioni umane obbligatorie oltre determinate soglie, contestabilità delle decisioni e metriche che privilegino la qualità decisionale rispetto alla sola velocità. La conclusione è chiara: l’IA continuerà a progredire — ma se la responsabilità resterà centrale o diventerà silenziosamente opzionale è una scelta progettuale che le organizzazioni compiono con ogni sistema che costruiscono.

L’IA non eliminerà la responsabilità. Ma può renderla opzionale — ed è lì che iniziano i veri costi.

All’inizio di un nuovo anno, le organizzazioni tendono a porsi domande familiari: cosa dovremmo costruire ora? Cosa dovremmo scalare? Cosa dovremmo automatizzare?

Molto più raramente ci poniamo la domanda più scomoda: che cosa dovremmo deliberatamente preservare?

L’IA sta accelerando rapidamente. Non perché le macchine siano improvvisamente capaci di tutto, ma perché molte decisioni relative a giudizio, responsabilità e titolarità decisionale vengono silenziosamente riprogettate nella sua ombra.

Ciò che segue non è un argomento contro l’IA o l’automazione. È un argomento contro qualcosa di ben più rilevante: la silenziosa trasformazione della responsabilità in un’opzione.

Ciò che scegliamo di seppellire

Il progresso raramente annuncia ciò che lascia dietro di sé.

Quando le organizzazioni parlano di innovazione, descrivono di solito ciò che viene guadagnato: velocità, efficienza, scala. Ciò che scompare nel processo spesso appare inizialmente insignificante — un controllo manuale, una seconda opinione, un momento di esitazione.

Con il tempo, queste assenze si accumulano.

Valori come il pensiero critico, la ricerca della verità, l’autonomia e la responsabilità non scompaiono perché l’IA li sostituisce. Sbiadiscono quando i sistemi vengono progettati in modo tale da non richiederli più.

Una volta che questi valori cessano di essere operativamente necessari, rischiano di diventare artefatti culturali — ammirati a posteriori, citati nelle dichiarazioni di missione, ma assenti nelle decisioni quotidiane.

Dopo l’aggiornamento

La responsabilità raramente viene rimossa per decreto. Viene rimossa attraverso le impostazioni predefinite.

Gli aggiornamenti di sistema introducono nuove azioni “raccomandate”. I dashboard danno priorità a determinate metriche. Le approvazioni automatizzate riducono l’attrito. Nessuno di questi cambiamenti appare problematico se considerato singolarmente.

Nel loro insieme, però, rimodellano il modo in cui vengono prese le decisioni: ciò che viene messo in discussione, ciò che viene dato per scontato e chi è chiamato a rispondere del risultato.

La ricerca sulla sicurezza descrive da tempo come i fallimenti nei sistemi complessi raramente derivino da un singolo errore catastrofico, ma da condizioni latenti incorporate nel tempo — assunzioni che restano invisibili fino a quando non si verifica un collasso (Reason, 1990).

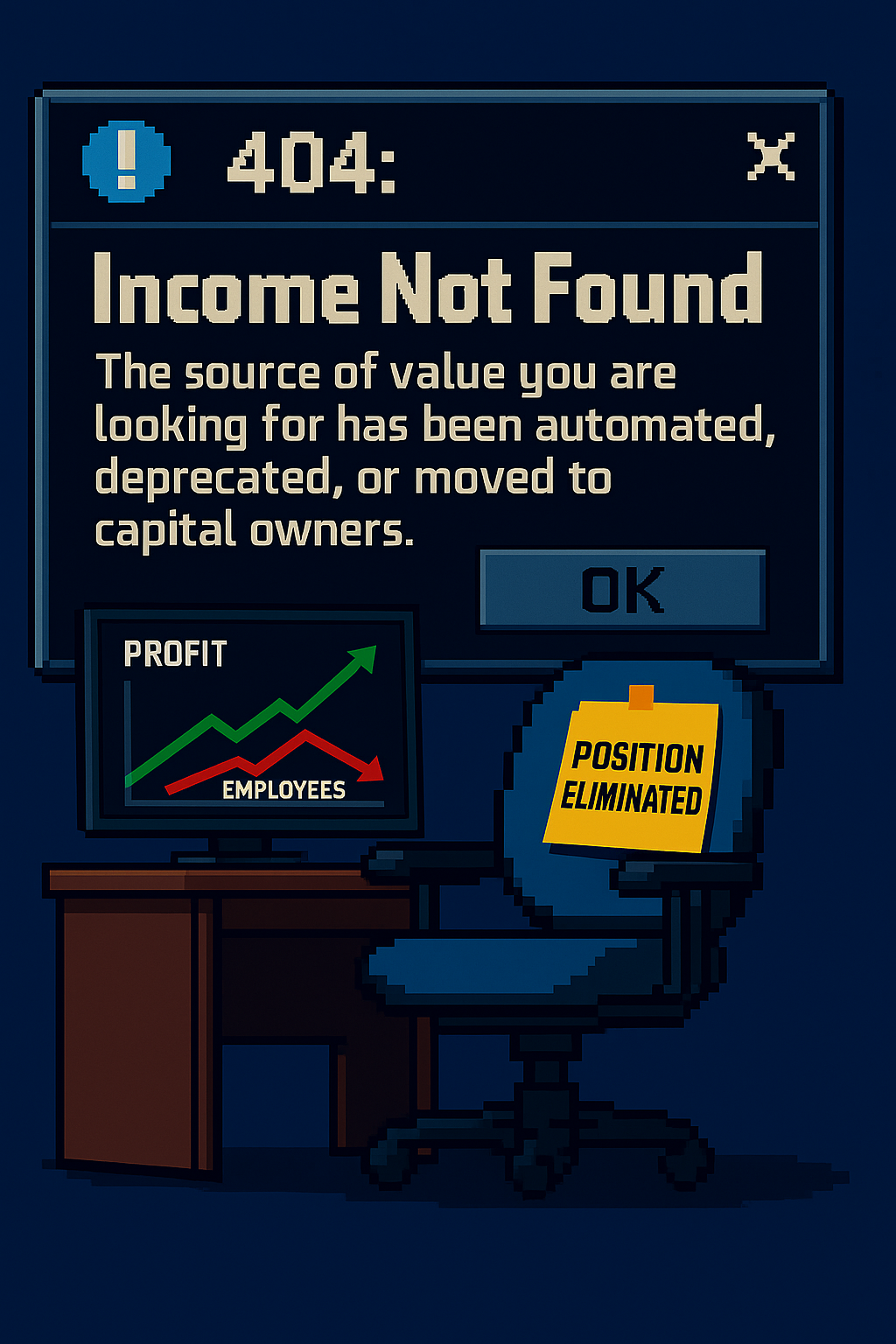

Negli ambienti supportati dall’IA, una di queste condizioni latenti è la graduale erosione della titolarità decisionale. Quando i risultati vengono prodotti da sistemi opachi, la responsabilità tende a diffondersi. Tutti partecipano — ma nessuno decide.

Esempio – La decisione “raccomandata” che nessuno si assume

Un’azienda introduce un flusso di lavoro supportato dall’IA che produce una “azione raccomandata” per l’onboarding dei clienti: approvare, rifiutare o escalare. Il controllo umano resta possibile — ma viene esplicitamente definito come opzionale.

Nell’interfaccia, approvare la raccomandazione richiede un solo clic. Deviare dalla raccomandazione richiede una giustificazione scritta, l’approvazione di un responsabile e introduce ritardi visibili. Sotto pressione temporale, i team imparano rapidamente quale percorso mantiene i dashboard “verdi”.

Mesi dopo emergono decisioni problematiche. Clienti legittimi sono stati rifiutati; altri sono stati approvati nonostante chiari segnali di allarme. Quando si chiede conto delle responsabilità, la tracciabilità si frammenta: il sistema ha raccomandato, un dipendente ha cliccato, il processo si è concluso.

Nessuna regola è stata violata. Nessun essere umano è stato rimosso. La responsabilità è stata semplicemente resa opzionale — e poi ottimizzata fuori dalla pratica quotidiana.

Quando l’intervento umano diventa opzionale

“Human in the loop” viene spesso citato come meccanismo di salvaguardia. Si presta molta meno attenzione a ciò che accade quando il ruolo umano viene inquadrato come opzionale.

L’opzionalità sembra ragionevole. Flessibile. Efficiente. Ma nella progettazione dei sistemi, i passaggi opzionali sono raramente neutrali. Sotto pressione, l’opzionale diventa rapidamente aggirabile. Ciò che è aggirabile viene ignorato. Ciò che viene ignorato diventa invisibile.

La ricerca sull’interazione uomo–automazione mostra da tempo che le persone possono sviluppare un bias dell’automazione — una fiducia eccessiva nelle uscite del sistema, anche quando il sistema è sbagliato (Parasuraman & Riley, 1997). Quando il giudizio è posizionato come opzione di riserva anziché come requisito, si atrofizza.

La responsabilità non scompare perché le persone smettono di preoccuparsene. Scompare perché i sistemi smettono di richiederla — e perché smettiamo di insistere affinché lo facciano.

- Reason, J. (1990). Human Error. Cambridge University Press. URL: https://books.google.co.uk/books/about/Human_Error.html?id=WJL8NZc8lZ8C

- Parasuraman, R.; & Riley, V. (1997). Humans and Automation: Use, Misuse, Disuse, Abuse. Human Factors, 39(2), 230–253. DOI: 10.1518/001872097778543886

- Autor, D. (2015). Why Are There Still So Many Jobs? The History and Future of Workplace Automation. Journal of Economic Perspectives, 29(3), 3–30. DOI: 10.1257/jep.29.3.3