Mit der zunehmenden Beschleunigung von KI und Automatisierung im Jahr 2026 besteht die zentrale Herausforderung für Organisationen nicht mehr in der technischen Leistungsfähigkeit, sondern in der Bewahrung menschlicher Verantwortung. Dieser Artikel argumentiert, dass das gravierendste Risiko von KI weder im Arbeitsplatzabbau noch in Maschinenfehlern liegt, sondern in der subtilen Umgestaltung von Verantwortung zu einer optionalen Eigenschaft moderner Systeme. Durch Defaults, Empfehlungen und automatisierte Workflows wird Verantwortung zunehmend nicht abgeschafft, sondern verteilt – bis Entscheidungen ohne klare Zuständigkeit getroffen werden.

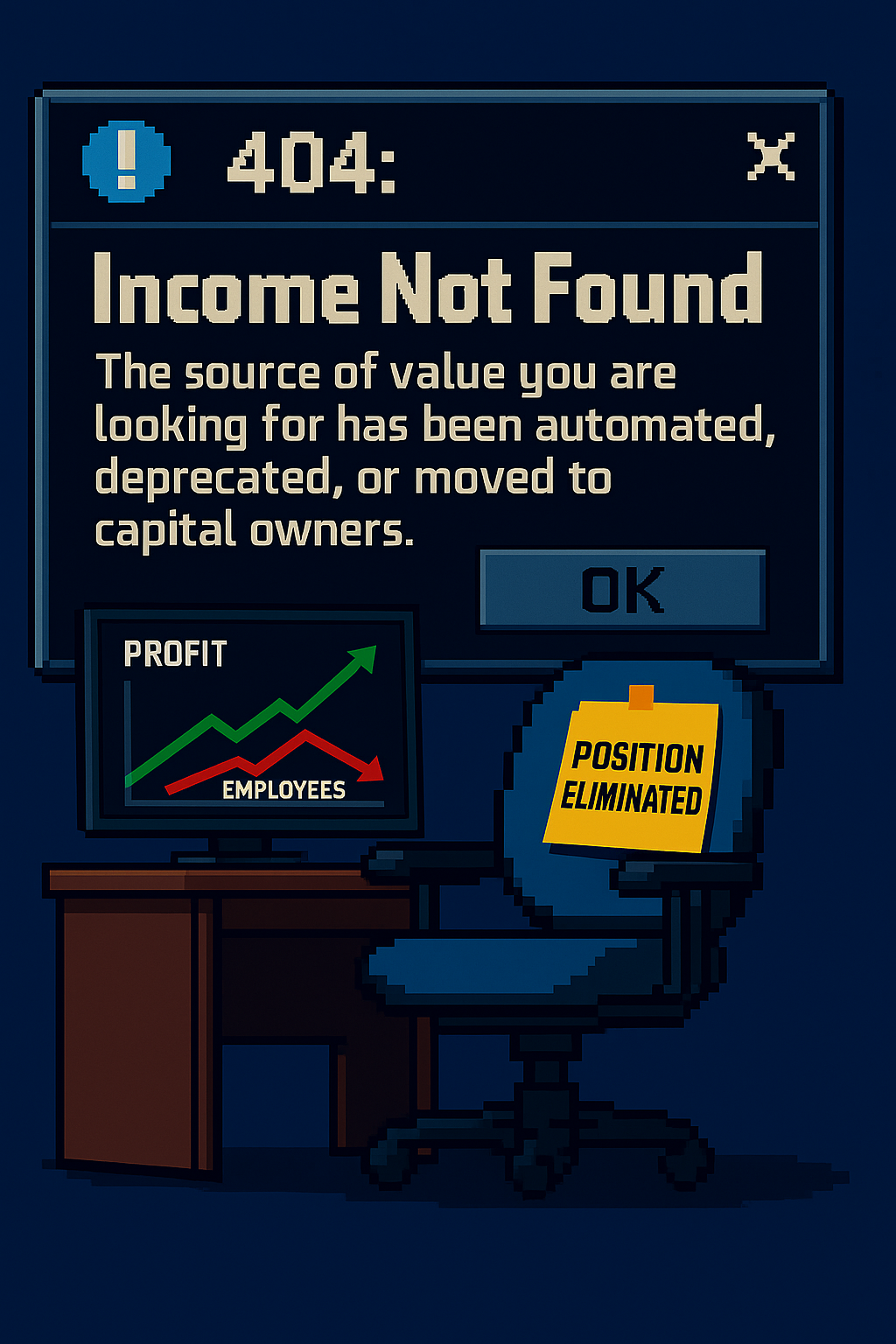

Der Artikel zeigt, dass Werte wie Urteilsvermögen, kritisches Denken und Verantwortlichkeit nicht deshalb verschwinden, weil KI sie ersetzt, sondern weil Systeme so gestaltet werden, dass sie diese nicht mehr benötigen. Optionale menschliche Kontrolle, Automatisierungsbias und auf Geschwindigkeit sowie Messbarkeit optimierte Leistungskennzahlen untergraben schrittweise die Entscheidungshoheit. Was sich nicht quantifizieren lässt – Kontext, Interpretation, langfristiges Urteilsvermögen – verliert Sichtbarkeit, Anerkennung und ökonomischen Wert.

Statt KI grundsätzlich abzulehnen, plädiert der Artikel für ein bewusstes Systemdesign, das menschliche Handlungsfähigkeit an entscheidenden Stellen explizit und unverhandelbar macht. Die Bewahrung von Verantwortung erfordert klare Entscheidungszuständigkeiten, verpflichtende menschliche Prüfungen ab definierten Schwellenwerten, Anfechtbarkeit sowie Kennzahlen, die Entscheidungsqualität höher bewerten als reine Geschwindigkeit. Das Fazit ist eindeutig: KI wird sich weiterentwickeln – doch ob Verantwortung zentral bleibt oder leise zur Option wird, ist eine Gestaltungsentscheidung, die Organisationen mit jedem System treffen, das sie bauen.

KI wird Verantwortung nicht abschaffen. Aber sie kann sie optional machen — und genau dort beginnen die eigentlichen Kosten.

Zu Beginn eines neuen Jahres stellen sich Organisationen meist vertraute Fragen: Was sollten wir als Nächstes bauen? Was sollten wir skalieren? Was sollten wir automatisieren?

Weitaus seltener stellen wir uns die unbequemere Frage: Was sollten wir bewusst bewahren?

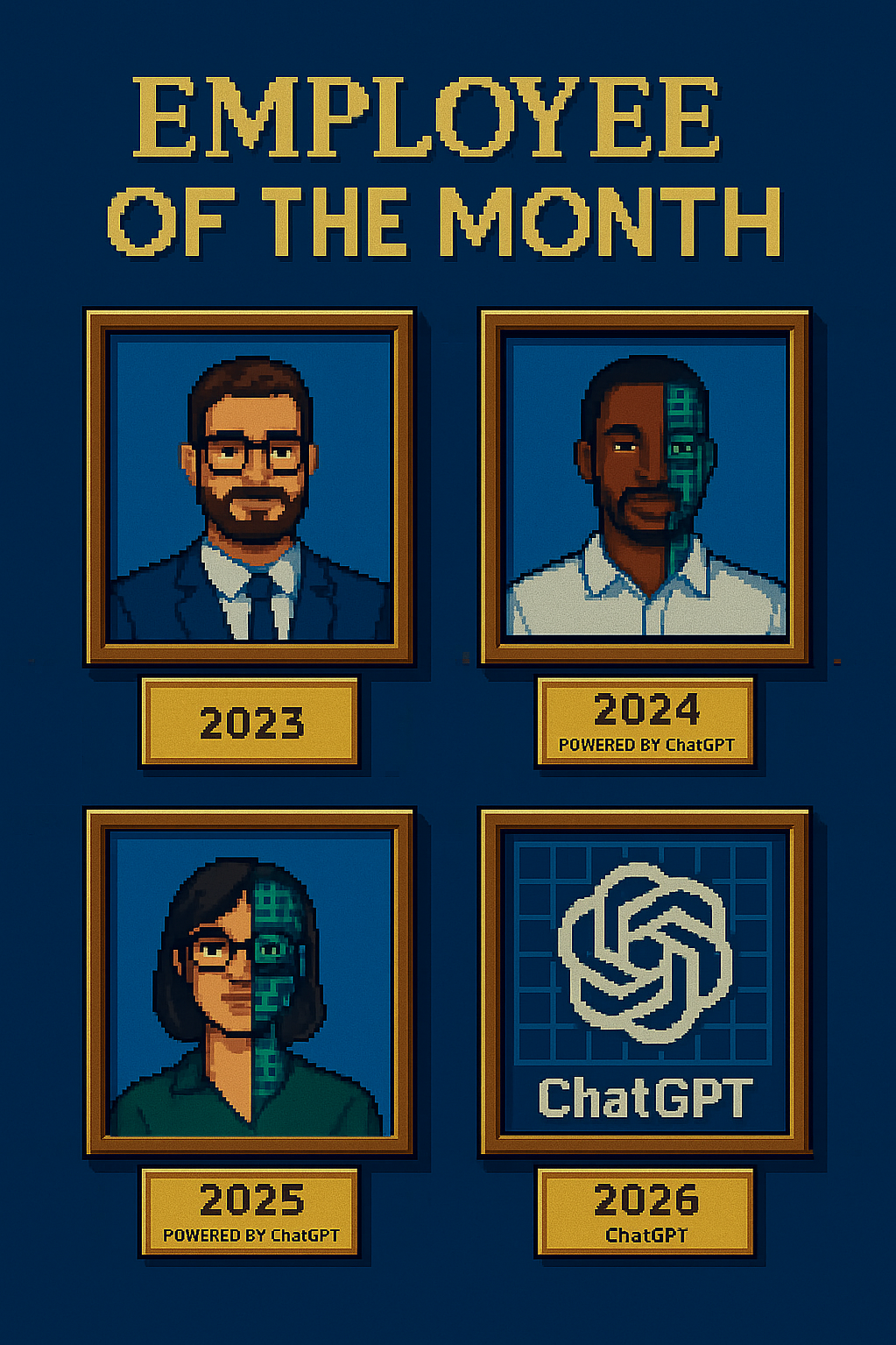

KI beschleunigt sich rasant. Nicht weil Maschinen plötzlich alles können, sondern weil viele Entscheidungen über Urteilsvermögen, Verantwortlichkeit und Entscheidungshoheit stillschweigend in ihrem Schatten neu gestaltet werden.

Was folgt, ist kein Argument gegen KI oder Automatisierung. Es ist ein Argument gegen etwas Weitaus Folgenreicheres: die stille Umgestaltung von Verantwortung zur Optionalität.

Was wir begraben

Fortschritt kündigt selten an, was er zurücklässt.

Wenn Organisationen über Innovation sprechen, beschreiben sie meist, was gewonnen wird: Geschwindigkeit, Effizienz, Skalierung. Was dabei verschwindet, wirkt zunächst oft unbedeutend — ein manueller Prüfschritt, eine zweite Meinung, ein Moment des Zögerns.

Mit der Zeit summieren sich diese Abwesenheiten.

Werte wie kritisches Denken, Wahrheitssuche, Autonomie und Verantwortung verschwinden nicht, weil KI sie ersetzt. Sie verblassen, wenn Systeme so entworfen werden, dass sie diese nicht mehr erfordern.

Sobald diese Werte operativ nicht mehr notwendig sind, drohen sie zu kulturellen Artefakten zu werden — geschätzt in Rückblicken, zitiert in Leitbildern, aber abwesend in alltäglichen Entscheidungen.

Nach dem Update

Verantwortung wird selten per Anordnung abgeschafft. Sie verschwindet durch Voreinstellungen.

System-Updates führen neue „empfohlene“ Aktionen ein. Dashboards priorisieren bestimmte Kennzahlen. Automatisierte Freigaben reduzieren Reibung. Keine dieser Änderungen wirkt für sich genommen problematisch.

Zusammengenommen jedoch verändern sie, wie Entscheidungen getroffen werden: was hinterfragt wird, was als gegeben gilt und wer das Ergebnis zu verantworten hat.

Die Sicherheitsforschung beschreibt seit Langem, dass Versagen in komplexen Systemen selten auf einen einzelnen katastrophalen Fehler zurückzuführen ist, sondern auf latente Bedingungen, die sich über Zeit einbetten — Annahmen, die unsichtbar bleiben, bis es zum Zusammenbruch kommt (Reason, 1990).

In KI-gestützten Umgebungen ist eine solche latente Bedingung die schleichende Erosion von Entscheidungshoheit. Wenn Ergebnisse von intransparenten Systemen erzeugt werden, diffundiert Verantwortung. Alle sind beteiligt — aber niemand entscheidet.

```html

Beispiel – Die „empfohlene“ Entscheidung, die niemand verantwortet

Ein Unternehmen führt einen KI-gestützten Workflow ein, der für das Kunden-Onboarding eine „empfohlene Aktion“ ausgibt: genehmigen, ablehnen oder eskalieren. Menschliche Prüfung ist weiterhin möglich — wird jedoch ausdrücklich als optional gekennzeichnet.

In der Benutzeroberfläche ist das Bestätigen der Empfehlung ein einzelner Klick. Ein Abweichen erfordert eine schriftliche Begründung, die Freigabe durch Vorgesetzte und führt zu sichtbaren Verzögerungen. Unter Zeitdruck lernen Teams schnell, welcher Weg die Dashboards grün hält.

Monate später treten problematische Entscheidungen zutage. Legitime Kunden wurden abgelehnt, andere trotz klarer Warnsignale genehmigt. Als nach Verantwortlichkeiten gefragt wird, zerfällt die Nachvollziehbarkeit: Das System empfahl, ein Mitarbeitender klickte, der Prozess lief durch.

Keine Regel wurde verletzt. Kein Mensch entfernt. Verantwortung wurde lediglich optional gemacht — und anschließend aus der Alltagspraxis herausoptimiert.

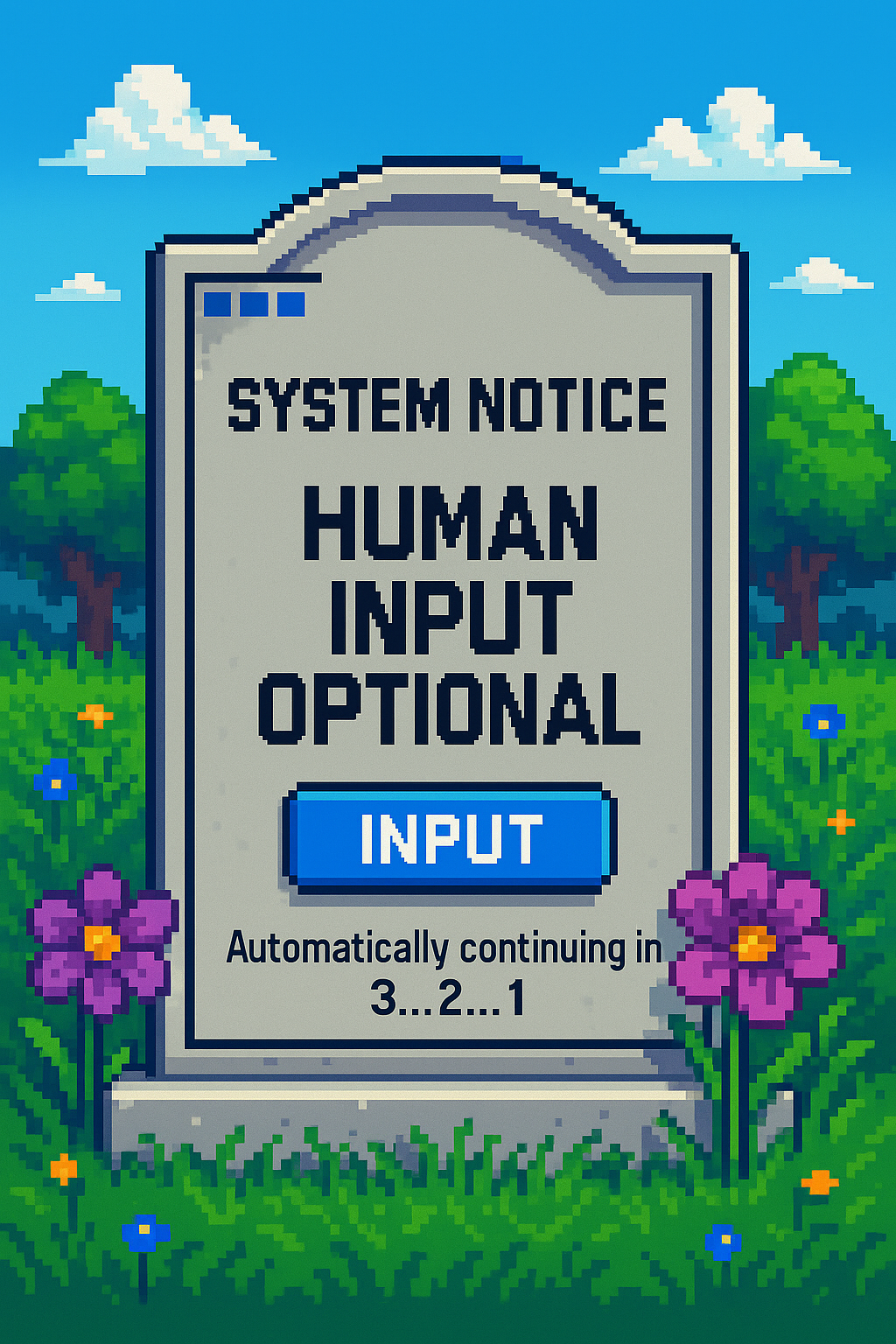

Wenn menschlicher Input optional wird

„Human in the loop“ wird häufig als Schutzmechanismus genannt. Weniger Beachtung findet, was geschieht, wenn die menschliche Rolle als optional gerahmt wird.

Optionalität klingt vernünftig. Flexibel. Effizient. Doch im Systemdesign sind optionale Schritte selten neutral. Unter Zeitdruck wird optional schnell überspringbar. Überspringbar wird ignoriert. Ignoriert wird unsichtbar.

Die Forschung zur Mensch–Automatisierungs-Interaktion zeigt seit Langem, dass Menschen einen Automatisierungsbias entwickeln können — ein übermäßiges Vertrauen in Systemausgaben, selbst wenn das System falsch liegt (Parasuraman & Riley, 1997). Wird Urteilsvermögen als Rückfalloption statt als Voraussetzung positioniert, verkümmert es.

Verantwortung verschwindet nicht, weil Menschen sich nicht mehr kümmern. Sie verschwindet, weil Systeme aufhören, sie einzufordern — und weil wir aufhören darauf zu bestehen.

- Reason, J. (1990). Human Error. Cambridge University Press. URL: https://books.google.co.uk/books/about/Human_Error.html?id=WJL8NZc8lZ8C

- Parasuraman, R.; & Riley, V. (1997). Humans and Automation: Use, Misuse, Disuse, Abuse. Human Factors, 39(2), 230–253. DOI: 10.1518/001872097778543886

- Autor, D. (2015). Why Are There Still So Many Jobs? The History and Future of Workplace Automation. Journal of Economic Perspectives, 29(3), 3–30. DOI: 10.1257/jep.29.3.3