Digitale sistemi vengono sempre più utilizzati per supportare l’applicazione di leggi e regolamenti. Tuttavia, attraverso impostazioni predefinite, regole di validazione e assunzioni tecniche incorporate nel codice, il software finisce spesso per imporre vincoli che vanno oltre la norma giuridica, senza legittimazione democratica né trasparenza. Questo fenomeno, definito compliance ombra, sposta di fatto il potere normativo dal legislatore e dalle autorità di controllo verso interfacce, API e architetture software.

L’articolo analizza la compliance ombra come un problema strutturale all’intersezione tra diritto, tecnologia e organizzazione. Mostra come regole applicate dal software possano escludere casi legittimi, limitare diritti, creare una conformità solo apparente e rendere opaca la responsabilità. Attraverso esempi concreti, viene evidenziata la necessità di una chiara separazione tra requisiti legali e loro implementazione tecnica, di documentazione tracciabile delle decisioni di conformità e di meccanismi di intervento umano. In assenza di queste salvaguardie, la compliance rischia di diventare tecnicamente rigorosa, ma giuridicamente infondata ed eticamente problematica.

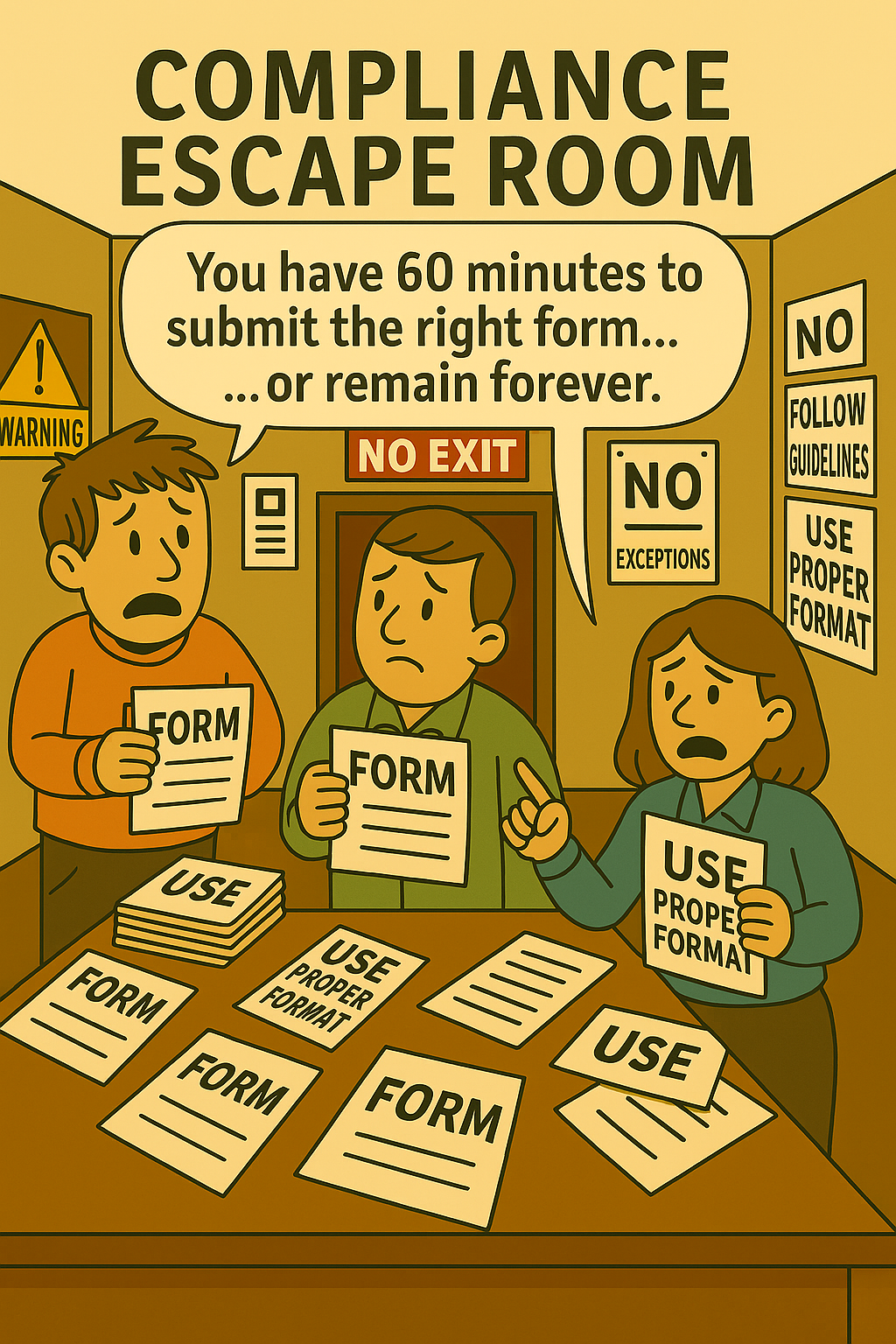

Immaginate di compilare un modulo ufficiale e scoprire che il sistema rifiuta il vostro vero nome, il vostro vero indirizzo o il vostro reale status legale. Non perché lo preveda la legge, ma perché il software non vi permette di procedere.

I sistemi digitali dovrebbero aiutarci a rispettare la legge – ma cosa succede se iniziano a definirla essi stessi? Poiché governi e aziende si affidano sempre più al software per far rispettare le normative, cresce un problema: la compliance ombra. Si tratta di regole e restrizioni imposte da strumenti software, API o piattaforme attraverso la loro implementazione tecnica – non tramite legislazione, processi democratici o dibattiti pubblici.

Quando il software fa le leggi

La conformità non è più solo una questione di testo di legge. Dipende da ciò che gli strumenti software permettono. Dai portali fiscali e sistemi di approvvigionamento fino agli algoritmi di moderazione dei contenuti, il software decide sempre più spesso cosa è permesso – o no. Queste decisioni sono spesso invisibili, prive di responsabilità e guidate da logiche tecniche piuttosto che giuridiche.

Esempi di compliance ombra

- ✘ Un modulo non può essere inviato finché non si spunta la casella di consenso GDPR – anche se in quel caso specifico il consenso non è legalmente richiesto.

- ✘ Un'API di fatturazione elettronica impone campi fiscali basati su interpretazioni obsolete o eccessivamente restrittive.

- ✘ Una piattaforma elimina automaticamente contenuti segnalati dall’IA come “potenzialmente dannosi” – senza contesto o possibilità di ricorso.

- ✘ Uno strumento di approvvigionamento esclude gli offerenti perché i loro documenti non corrispondono a un formato predefinito (ma non obbligatorio).

Perché succede

- Sovraestensione tecnica: Gli sviluppatori codificano interpretazioni delle regole per garantire coerenza – ma eliminano le sfumature.

- Avversione al rischio: Le aziende implementano restrizioni eccessivamente severe per evitare responsabilità – non necessariamente per rispettare accuratamente la legge.

- Mancanza di contesto legale: I team software lavorano senza consulenza giuridica, portando a implementazioni rigide o errate.

- Pressione all’automazione: I processi di conformità vengono scalati tramite software – sacrificando flessibilità e capacità di giudizio.

Realtà normativa 2025: Molti aspetti della compliance ombra non derivano da leggi (male interpretate), ma da linee guida per gli appalti, impostazioni predefinite e regole di validazione degli strumenti software. Anche se le normative sull’IA e le leggi sulle piattaforme richiedono trasparenza, gestione del rischio e supervisione umana, le reali decisioni di implementazione restano spesso invisibili. Una possibile soluzione sarebbe rendere obbligatorie documentazioni che coprano dall’esigenza iniziale fino all’implementazione concreta (requisito, approccio alla soluzione, implementazione inclusi i passaggi di validazione; verifica della conformità dell’implementazione con l’intento della norma giuridica di riferimento), registri di modifiche tracciabili e canali di reclamo e di override facilmente accessibili direttamente nel sistema.

I rischi nascosti

- ⚠ Cittadini e imprese possono essere esclusi da servizi o diritti senza una base legale.

- ⚠ Le organizzazioni possono ritenersi “conformi” pur applicando interpretazioni non vincolanti o addirittura errate.

- ⚠ La responsabilità diventa ambigua: chi è responsabile della regola – l’autorità, lo sviluppatore o il fornitore?

“Quando le regole sono fatte rispettare dalle macchine, si smette di metterle in discussione – anche quando sono sbagliate o contrarie alla legge.”

Caso reale – Sistemi universitari e la trappola del nome

Nei sistemi digitali pubblici spesso confondiamo ciò che è legalmente richiesto con ciò che è tecnicamente previsto. Quando i moduli rifiutano identità reali perché non rientrano in maschere di input predefinite, non stiamo più applicando la legge – stiamo applicando lo schema del database.

Un esempio particolarmente evidente si trova nei sistemi di candidatura delle università. Sia i candidati che il personale amministrativo devono spesso inserire obbligatoriamente un “nome” e un “cognome” – non perché lo richieda la legge, ma perché lo impone il software. I campi di input sono obbligatori e il sistema rifiuta gli invii che non rispettano questa struttura. Persone con un solo nome legale – come avviene in paesi come l’Indonesia, parti dell’India o il Myanmar – sono costrette a inventare dati fittizi solo per superare la validazione.

Questa assunzione tecnica di un formato di nome occidentale si propaga in tutto il sistema. Una volta che i dati sono archiviati in questa struttura rigida, alimentano processi a valle che si basano sulla loro “correttezza”. Se un amministratore aggira il modulo e inserisce un singolo nome direttamente nel database per riflettere la realtà legale, il sistema può andare in errore. La generazione dei certificati nella gestione degli esami può fallire, poiché modelli e logiche di elaborazione dipendono dalla presenza sia del nome che del cognome. Anche il sistema di posta elettronica dell’università può non essere in grado di generare un indirizzo, poiché si aspetta di concatenare nome e cognome in formati come nome.cognome@universita.it.

Così una finzione burocratica viene imposta dal codice. Ciò che è tecnicamente previsto diventa più potente di ciò che è legalmente vero. Il risultato è un’esclusione silenziosa: identità che non corrispondono alla struttura del sistema vengono rifiutate o forzatamente adattate. Non è applicazione della legge – è conformità imposta dal software.

Verso una compliance trasparente

La compliance ombra non è solo un problema tecnico – è un problema democratico. Per affrontarlo, servono:

- ✓ Chiara separazione tra legge e applicazione supportata da strumenti software

- ✓ Revisioni legali della logica di conformità nei flussi di lavoro software

- ✓ Possibilità di intervento umano e segnalazione trasparente degli errori

- ✓ Governance multi-stakeholder per le piattaforme di compliance

Conclusione

Gli strumenti digitali possono supportare l’applicazione delle regole – ma non devono definirle.

Quando interfacce utente e codice iniziano a plasmare la propria conformità, servono controlli e contrappesi che garantiscano sia l’accuratezza legale che la responsabilità democratica.

Altrimenti rischiamo di costruire sistemi tecnicamente precisi – ma giuridicamente infondati ed eticamente discutibili.

La compliance ombra può essere invisibile – ma le sue conseguenze no. È ora di portare alla luce queste regole prive di legittimità legale.

- Hildebrandt, M. (2017). Law As Computation in the Era of Artificial Legal Intelligence: Speaking Law to the Power of Statistics. SSRN Working Paper. URL: https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2983045

- O’Neil, C. (2016). Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. Crown Publishing Group. URL: https://www.amazon.com/dp/0553418815

- European Commission. (2021). Proposal for a Regulation on Artificial Intelligence (Artificial Intelligence Act). URL: https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A52021PC0206

- Gillespie, T. (2018). Custodians of the Internet: Platforms, Content Moderation, and the Hidden Decisions That Shape Social Media. Yale University Press. URL: https://yalebooks.yale.edu/book/9780300261431/custodians-of-the-internet/

- Zuboff, S. (2019). The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power. PublicAffairs. URL: http://www.amazon.com/dp/1610395697